AI抓取需要开放哪些Robots蜘蛛权限?国内与国外完整介绍

在数字化时代,人工智能(AI)驱动的大规模数据抓取(或称网络爬虫)已成为企业进行市场分析、竞争情报、价格监控和机器学习模型训练的关键手段。然而,不负责任的抓取行为会对网站服务器造成压力,甚至可能引发法律风险。

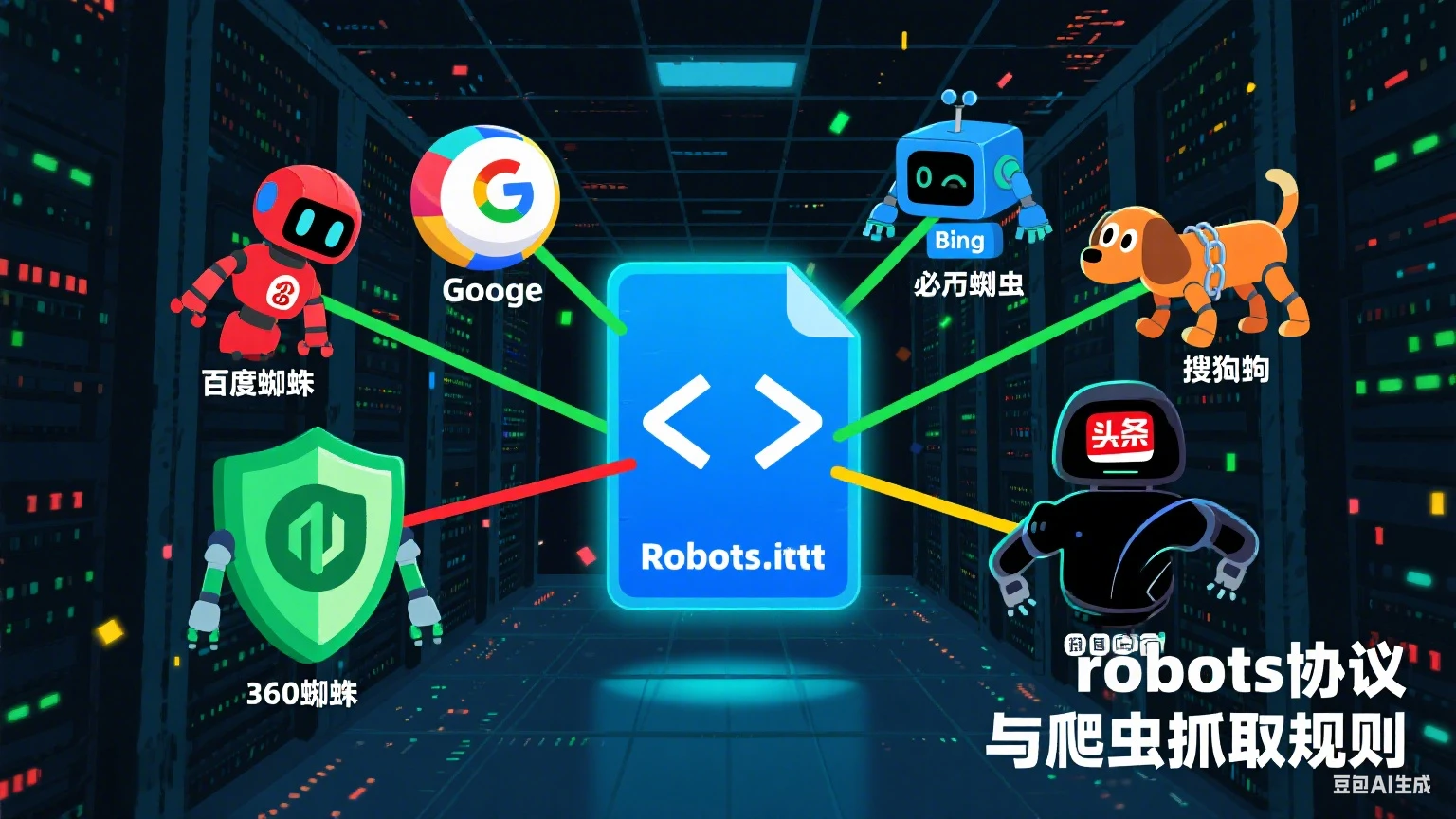

作为网站所有者,如何平衡数据开放与服务器安全?作为AI项目的开发者,如何合规、高效地获取数据?这一切的起点都源于一个看似简单却至关重要的协议:Robots Exclusion Protocol( robots.txt 协议)。

作为网站所有者,如何平衡数据开放与服务器安全?作为AI项目的开发者,如何合规、高效地获取数据?这一切的起点都源于一个看似简单却至关重要的协议:Robots Exclusion Protocol( robots.txt 协议)。

本文将从网站所有者的角度出发,全面介绍应对国内外主流AI蜘蛛(Spider/Bot)时应开放的robots.txt权限策略,并兼顾开发者的视角。

一、 基础认知:什么是robots.txt?

robots.txt 是一个放在网站根目录(如 www.yoursite.com/robots.txt)的文本文件。它用于告知合规的网络蜘蛛(爬虫)哪些目录或文件可以抓取,哪些不可以。它更像一个“君子协定”,依赖于爬虫的自觉遵守。恶意爬虫通常会无视此协议。

基本语法:

User-agent: [蜘蛛名称] Disallow: [禁止抓取的目录/文件] Allow: [允许抓取的目录/文件(通常用于在Disallow中例外)]

二、 针对主流AI蜘蛛的权限开放策略

AI蜘蛛通常分为两类:

-

搜索引擎的AI蜘蛛:如Googlebot、Baiduspider,它们抓取内容用于索引和排名。

-

第三方/商业AI数据采集蜘蛛:这些蜘蛛可能来自特定的AI公司、数据分析机构或研究项目,用于聚合信息训练模型。

以下是针对国内外常见蜘蛛的详细配置建议。

A. 国外主流AI与搜索引擎蜘蛛

-

Googlebot (谷歌)

-

重要性:全球最大的搜索引擎,对网站流量和品牌曝光至关重要。

-

User-agent:

Googlebot -

建议配置:

-

开放:除非有极度敏感的内容,否则建议允许抓取所有希望被索引和排名的页面。可以特别允许对产品页、博客文章、知识库等高质量内容的抓取。

-

限制:使用

Disallow屏蔽后台登录页(/admin/)、用户隐私数据页(/user/)、临时文件、API接口、站内搜索结果页(/search?)等,以避免重复内容和资源浪费。

-

-

示例:

User-agent: Googlebot Allow: / Disallow: /admin/ Disallow: /user/ Disallow: /search?

-

-

GPTBot (OpenAI)

-

重要性:用于抓取网络信息以训练OpenAI的模型(如ChatGPT)。允许其抓取意味着你的内容可能成为AI模型的知识来源,增加品牌在AI产品中的可见度。

-

User-agent:

GPTBot -

官方声明:OpenAI鼓励网站所有者通过robots.txt来控制GPTBot的访问。

-

建议配置:

-

若希望被抓取:完全允许。

User-agent: GPTBot Allow: / -

若希望完全禁止:完全禁止。

User-agent: GPTBot Disallow: / -

若部分允许:例如,只允许抓取博客和新闻栏目,屏蔽价格和产品页。

-

-

示例(部分允许):

User-agent: GPTBot Allow: /blog/ Allow: /news/ Disallow: /product/ # 屏蔽产品详情页 Disallow: /price/ # 屏蔽价格页 Crawl-delay: 2 # 建议抓取延迟(非官方标准,但部分蜘蛛支持)

-

-

CCBot (Common Crawl)

-

重要性:非营利性组织,抓取网络数据并构建巨大的公开数据集,供全球研究人员、企业(包括AI公司)使用。其数据集是许多AI项目的基础。

-

User-agent:

CCBot -

建议配置:策略与GPTBot类似。允许CCBot抓取等同于将内容贡献给一个开放的科学与研究社区。

-

示例:

User-agent: CCBot Allow: /public-data/ Disallow: /private/

-

-

其他国际AI蜘蛛

-

Bingbot (微软):

User-agent: Bingbot,重要性仅次于Googlebot,配置策略可参照Googlebot。 -

Applebot (苹果):

User-agent: Applebot,用于Siri和Spotlight建议,也应给予类似权限。 -

Facebookbot/Meta: 主要用于抓取分享链接的预览信息,可根据需要开放。

-

B. 国内主流AI与搜索引擎蜘蛛

-

Baiduspider (百度)

-

重要性:中国最大的搜索引擎,是国内流量的核心来源。

-

User-agent:

Baiduspider -

建议配置:策略与Googlebot基本一致。务必确保核心内容对其开放,同时屏蔽无价值的页面。百度对robots.txt的遵守程度较高。

-

示例:

User-agent: Baiduspider Allow: / Disallow: /admin/ Disallow: /data/ Disallow: /login.php

-

-

360Spider (360搜索) / Sogouspider (搜狗搜索) / Yisouspider (神马搜索)

-

重要性:国内重要的二级搜索引擎渠道,根据网站用户群体决定其重要性。

-

User-agent:

360Spider,Sogouspider,Yisouspider -

建议配置:通常跟随Baiduspider的策略即可。如果服务器资源紧张,可以适当限制其抓取频率(通过

Crawl-delay),但优先保证内容开放。

-

-

国内AI公司蜘蛛

-

目前,国内如百度文心、阿里通义、讯飞星火等AI厂商尚未公开其专用的数据采集蜘蛛的User-agent标识。它们可能:

-

使用通用标识(如

python-requests或Java等)。 -

委托第三方数据公司采集。

-

使用搜索引擎已有索引。

-

-

应对策略:对于未声明的蜘蛛,很难单独配置。重点是做好对已知蜘蛛(如Baiduspider)的配置,并通过以下通用策略进行管理。

-

三、 通用配置原则与高级策略(针对所有蜘蛛)

-

通用匹配符

*:

使用User-agent: *来为所有未单独指定的蜘蛛设置通用规则。User-agent: * Disallow: /admin/ Disallow: /cgi-bin/ Disallow: /tmp/ Disallow: /private/ Crawl-delay: 1 # 为所有蜘蛛设置1秒延迟,防止服务器过载

-

站点地图(Sitemap):

在robots.txt末尾指定XML站点地图的位置,帮助蜘蛛高效发现和索引所有重要页面。Sitemap: https://www.yoursite.com/sitemap.xml

-

谨慎使用

Crawl-delay:

虽然不是所有蜘蛛都支持,但它能有效控制抓取频率,保护服务器资源。百度和Google更推荐在其各自的站长平台中设置抓取频率。 -

区分移动端和桌面端蜘蛛:

例如,Google有Googlebot(桌面)和Googlebot-Mobile(移动),可根据需要微调配置。

四、 给开发者的建议:如何合规抓取

如果你是AI项目的开发者,需要抓取数据:

-

首要原则:尊重 robots.txt:在编写爬虫时,第一要务是解析目标网站的

robots.txt并严格遵守其规则。这是法律合规(如避免侵犯计算机信息系统罪)和道德的基本要求。 -

明确标识User-agent:在你的蜘蛛请求头(Header)中使用清晰、可识别的User-agent字符串(如

YourCompany-AIBot/1.0),并附上联系方式或网页,方便网站管理员联系你。 -

控制抓取频率:设置合理的请求延迟(如每秒1次),绝对避免并发大量请求导致对方服务器瘫痪。

-

获取明确许可:对于特别重要的数据源,尝试联系网站所有者,获取正式的API接口或抓取授权。

总结

| 蜘蛛名称 (User-agent) | 来源 | 建议策略 | 备注 |

|---|---|---|---|

| Googlebot | 谷歌搜索 | 优先开放核心内容,屏蔽无用页面 | 流量核心,必须重视 |

| GPTBot | OpenAI | 选择性开放:允许博客/新闻,屏蔽私密数据 | 控制AI模型的知识来源 |

| CCBot | Common Crawl | 建议开放公共内容 | 贡献研究,提升影响力 |

| Baiduspider | 百度搜索 | 优先开放核心内容,屏蔽无用页面 | 国内流量核心,必须重视 |

| 360Spider 等 | 国内搜索 | 跟随百度策略 | 次要流量来源 |

| **User-agent: *** | 所有其他蜘蛛 | 严格限制敏感目录,设置抓取延迟 | 服务器安全和隐私保护的第一道防线 |

核心思想:配置 robots.txt 不是一个“是否开放”的问题,而是一个“如何智能地开放”的问题。通过精细化的管理,网站所有者可以既拥抱AI和搜索引擎带来的流量与机遇,又能有效地保护关键资源和服务器稳定性,实现双赢。

扫码访问小程序中的本文